嗨,我是小壮!

今儿咱们聊聊Pytorch中的优化器。

优化器在深度学习中的选择直接影响模型的训练效果和速度。不同的优化器适用于不同的问题,其性能的差异可能导致模型更快、更稳定地收敛,或者在某些任务上表现更好。

因此,选择合适的优化器是深度学习模型调优中的一个关键决策,能够显著影响模型的性能和训练效率。

PyTorch本身提供了许多优化器,用于训练神经网络时更新模型的权重。

常见优化器

咱们先列举PyTorch中常用的优化器,以及简单介绍:

(1) SGD (Stochastic Gradient Descent)

随机梯度下降是最基本的优化算法之一。它通过计算损失函数关于权重的梯度,并沿着梯度的负方向更新权重。

optimizer = torch.optim.SGD(model.parameters(), lr=learning_rate)

(2) Adam

Adam是一种自适应学习率的优化算法,结合了AdaGrad和RMSProp的思想。它能够自适应地为每个参数计算不同的学习率。

optimizer = torch.optim.Adam(model.parameters(), lr=learning_rate)

(3) Adagrad

Adagrad是一种自适应学习率的优化算法,根据参数的历史梯度调整学习率。但由于学习率逐渐减小,可能导致训练过早停止。

optimizer = torch.optim.Adagrad(model.parameters(), lr=learning_rate)

(4) RMSProp

RMSProp也是一种自适应学习率的算法,通过考虑梯度的滑动平均来调整学习率。

optimizer = torch.optim.RMSprop(model.parameters(), lr=learning_rate)

(5) Adadelta

Adadelta是一种自适应学习率的优化算法,是RMSProp的改进版本,通过考虑梯度的移动平均和参数的移动平均来动态调整学习率。

optimizer = torch.optim.Adadelta(model.parameters(), lr=learning_rate)

一个完整案例

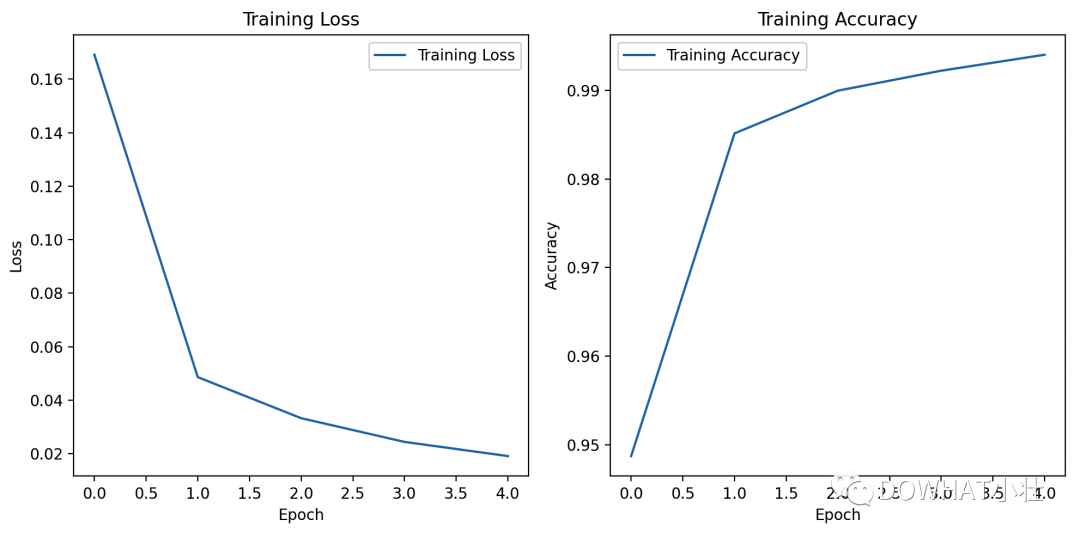

在这里,咱们聊聊如何使用PyTorch训练一个简单的卷积神经网络(CNN)来进行手写数字识别。

这个案例使用的是MNIST数据集,并使用Matplotlib库绘制了损失曲线和准确率曲线。

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

import matplotlib.pyplot as plt

# 设置随机种子

torch.manual_seed(42)

# 定义数据转换

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize((0.5,), (0.5,))])

# 下载和加载MNIST数据集

train_dataset = datasets.MNIST(root='./data', train=True, download=True, transform=transform)

test_dataset = datasets.MNIST(root='./data', train=False, download=True, transform=transform)

train_loader = DataLoader(train_dataset, batch_size=64, shuffle=True)

test_loader = DataLoader(test_dataset, batch_size=1000, shuffle=False)

# 定义简单的卷积神经网络模型

class CNN(nn.Module):

def __init__(self):

super(CNN, self).__init__()

self.conv1 = nn.Conv2d(1, 32, kernel_size=3, stride=1, padding=1)

self.relu = nn.ReLU()

self.pool = nn.MaxPool2d(kernel_size=2, stride=2)

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, stride=1, padding=1)

self.fc1 = nn.Linear(64 * 7 * 7, 128)

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.conv1(x)

x = self.relu(x)

x = self.pool(x)

x = self.conv2(x)

x = self.relu(x)

x = self.pool(x)

x = x.view(-1, 64 * 7 * 7)

x = self.fc1(x)

x = self.relu(x)

x = self.fc2(x)

return x

# 创建模型、损失函数和优化器

model = CNN()

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 训练模型

num_epochs = 5

train_losses = []

train_accuracies = []

for epoch in range(num_epochs):

model.train()

total_loss = 0.0

correct = 0

total = 0

for inputs, labels in train_loader:

optimizer.zero_grad()

outputs = model(inputs)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

total_loss += loss.item()

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

accuracy = correct / total

train_losses.append(total_loss / len(train_loader))

train_accuracies.append(accuracy)

print(f"Epoch {epoch+1}/{num_epochs}, Loss: {train_losses[-1]:.4f}, Accuracy: {accuracy:.4f}")

# 绘制损失曲线和准确率曲线

plt.figure(figsize=(10, 5))

plt.subplot(1, 2, 1)

plt.plot(train_losses, label='Training Loss')

plt.title('Training Loss')

plt.xlabel('Epoch')

plt.ylabel('Loss')

plt.legend()

plt.subplot(1, 2, 2)

plt.plot(train_accuracies, label='Training Accuracy')

plt.title('Training Accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.legend()

plt.tight_layout()

plt.show()

# 在测试集上评估模型

model.eval()

correct = 0

total = 0

with torch.no_grad():

for inputs, labels in test_loader:

outputs = model(inputs)

_, predicted = torch.max(outputs.data, 1)

total += labels.size(0)

correct += (predicted == labels).sum().item()

accuracy = correct / total

print(f"Accuracy on test set: {accuracy * 100:.2f}%")

上述代码中,我们定义了一个简单的卷积神经网络(CNN),使用交叉熵损失和Adam优化器进行训练。

在训练过程中,我们记录了每个epoch的损失和准确率,并使用Matplotlib库绘制了损失曲线和准确率曲线。

我是小壮,下期见!

原文地址:https://mp.weixin.qq.com/s?__biz=MzkyNzM4NzE0OA==&mid=2247484066&idx=1&sn=fe7ecb00363c25f8fa72753d343e0403